Apple y sus rivales apuestan su futuro en los sueños de estos hombres. Una historia oral de la inteligencia artificial, según lo dicho por sus padrinos, moscones y Justin Trudeau.

En los últimos cinco años, inteligencia artificial ha pasado de vaporware perenne a una de las esperanzas más brillantes de la industria de la tecnología. Las computadoras han aprendido a reconocer las caras y objetos, entender la palabra hablada y traducir decenas de idiomas. Compañías más grandes del mundo,alfabeto, Amazon.com, Apple, Facebooky Microsoft, han apostado su futuro en gran parte por AI, carreras para ver quien es más rápido en la construcción de máquinas más inteligentes. Ha alimentado la percepción que AI ha llegado de la nada, con uno mismo-conducción coches Teslay Alexa charlando a su hijo. Pero esto no fue éxito durante la noche, tampoco fue la creación de un único empresario de Silicon Valley.

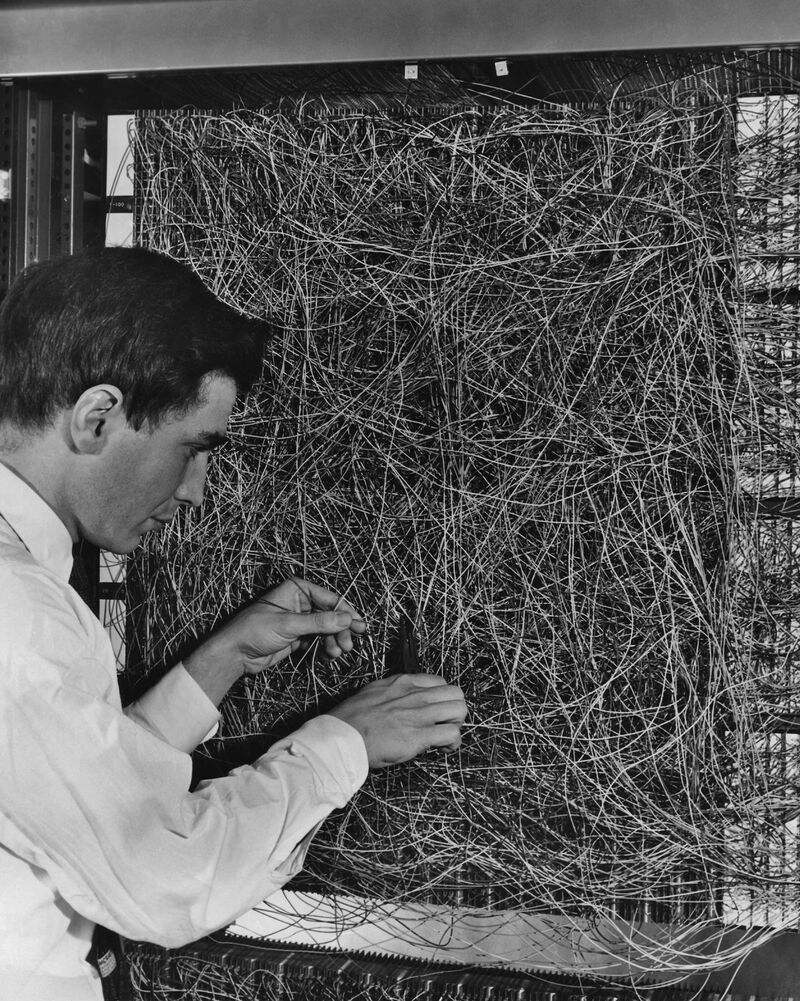

Las ideas modernas AI, redes neuronales y el aprendizaje de máquina, tienen raíces puede remontar a las últimas etapas de la II Guerra Mundial. Entonces, académicos estaban empezando a construir sistemas informáticos para almacenar y procesar información de manera similar al cerebro humano. Durante décadas, la tecnología tuvo sus altibajos, pero no logró captar la atención de científicos ampliamente hasta que alrededor del 2012, gracias a un puñado de investigadores persistentes que no teme al ridículo. Quedaron convencidos que redes de los nervios serían luz del mundo y alterar el destino de la humanidad.

Mientras que estos pioneros estaban esparcidos alrededor del mundo, que pasó a ser una concentración inusualmente grande de devotos red neurales en Canadá. Eso es solamente en parte por suerte: respaldados por el gobierno Instituto canadiense de investigación avanzada (Cifar) atrajo a un pequeño grupo de académicos en el país mediante la financiación de investigación red neural cuando era cosa de moda. Respaldo a científicos como Geoffrey Hinton y Yann LeCun en la Universidad de Toronto, Yoshua Bengio en la Universidad de Montreal y la Universidad de Alberta Richard Sutton, animándoles a compartir ideas y se adhieren a sus creencias. Vinieron para arriba con muchos de los conceptos que alimentó la revolución AI, y todos ahora consideran a los padrinos de la tecnología. Esta es la peculiar historia, reconstruye de mis entrevistas con ellos, de por qué tomó tanto tiempo para redes de los nervios trabajar, como estos científicos pegan, y por qué Canadá, de todos los lugares, terminó como la plataforma para el surgimiento de las máquinas.

(Ahora, no todos están de acuerdo con el lugar de Canadá. Ver si puede investigador alemán Jürgen Schmidhuber a continuación del punto y averiguar por qué está tan molesto aquí.)

Dentro de eso, es un subconjunto de la máquina de aprendizaje denominado aprendizaje profundo. La idea es construir una red neuronal, y tiene pesos y sesgos que pueden ser ajustados a casa en el resultado deseado. Se permite que la computadora iterar y evolucionar a la resolución de problemas. Eso es lo que Geoff Hinton y otros han realmente trabajado en las últimas décadas, y ahora es la base de lo que es más emocionante sobre AI. Hace un mejor trabajo de mímico la forma de que un cerebro humano piensa.

CADE METZ, reportero del New York Timesy autor de una historia próxima de AI: la idea de una red neuronal se remonta a la década de 1940 — la noción de un sistema informático que imitan a la red de neuronas en el cerebro. Pero un tipo llamado Frank Rosenblatt realmente el trabajo adelante en la década de 1950. Fue profesor y también estaba trabajando con la marina de guerra de Estados Unidos y otras partes del gobierno, y él desarrolló esta cosa llamada un Perceptrón basada en el concepto de red neuronal. Cuando él lo reveló, lugares como los tiempos de Nueva Yorky el New Yorkerlo cubrieron en términos bastante grandes.

Rosenblatt afirma que no sólo aprendería a hacer pequeñas tareas como reconocer imágenes pero también en teoría podría enseñar máquinas para caminar y para hablar y mostrar emoción. Pero fue una sola capa de neuronas, y eso significaba que era extremadamente limitado en lo que podría hacer. Ni que decir, ninguna de las cosas que prometió sucedió realmente.

Marvin Minsky, un colega de Rosenblatt, que pasó a ser uno de sus compañeros de escuela viejos del Bronx, escribió un libro en la década de 1960 que detallan las limitaciones del Perceptrón y redes neuronales, y tipo de puesto toda la zona de investigación en un congelador por lo menos 10 años.

GEOFF HINTON: Perceptrón de Rosenblatt podría hacer algunas cosas interesantes, pero llegó por delante de él por cerca de 50 años. Mientras que Minsky ha sido especie de creyente en redes de los nervios, fue capaz de mostrar que había ciertas cosas que no podían afrontar. El libro de Minsky y Seymour Papert en la tecnología (perceptrones: Introducción a la geometría computacional) básicamente condujo a la desaparición del campo.

Durante la década de 1970 un grupo pequeño de personas siguió trabajando en redes de los nervios, pero en general estábamos en medio de un invierno del AI.

METZ: Geoff Hinton, en Carnegie Mellon University y luego en la Universidad de Toronto, pegado con la idea de red de los nervios. Finalmente él y sus colaboradores y otros desarrollaron una red neuronal multicapa, una red neuronal profunda — y esto comenzó a trabajar en muchas formas.

Un informático francés, Yann LeCun, pasó un año haciendo la investigación postdoctoral en el laboratorio de Hinton en Toronto. LeCun entonces fue contratado por laboratorios Bell en Nueva Jersey.

YANN LECU

N: yo estaba fascinado por la inteligencia como un todo desde una edad muy temprana. Crecí en la década de 1960, por lo que no hubo exploración del espacio, la aparición de los primeros ordenadores y AI. Cuando comencé a estudiar ingeniería, estaba realmente interesado en inteligencia artificial, un campo era muy incipiente.

Escuché sobre el perceptrón y estaba intrigada, porque pensaba que el aprendizaje fue una parte integral de la inteligencia. Cavé alrededor para encontrar todo lo que pude sobre el perceptrón. Como ingeniero, si quieres entender la inteligencia, el acercamiento obvio es intentar construir una máquina inteligente, le obliga a centrarse en los componentes necesarios para fomentar la inteligencia. Es un poco como cómo los pioneros de la aviación se inspiraron en las aves, pero realmente no copian exactamente. No quiero sólo imitar la inteligencia biológica o el cerebro, porque hay un montón de aspectos de su función sólo debido a la bioquímica y la biología, no son pertinentes a la inteligencia, realmente. Gusta cómo plumas no son cruciales para el vuelo: lo que es importante son los principios aerodinámicos.

METZ: Hubo gente que pensó que lecun era una tuerca completa y se trataba de una tarea de Sísifo. Vas a estas grandes conferencias de la AI como un investigador de redes neuronales, y no eran aceptados por el núcleo de la academia. Estas ideas estaban en los márgenes.

YOSHUA BENGIO: En 1985, redes de los nervios eran una cosa marginal y no enseñadas en mis clases en la Universidad McGill. Me enseñaron la IA clásica, simbólico. Así que tuve que convencer a mi profesor para supervisarme haciendo redes de los nervios. Tuve una beca del gobierno, así que básicamente pude elegir mi tema, y no le costó nada al profesor. Hicimos un trato que podría aprender de la máquina, pero se aplicaría a lo que importaba, que era el reconocimiento de voz.

LECUN: En 1986, hubo un período de euforia alrededor de redes de los nervios, en parte debido al interés en los modelos de los físicos que vinieron para arriba con nuevas técnicas matemáticas. Eso hizo aceptable el campo otra vez, y esto condujo a una gran cantidad de emoción en la década de 1980 y principios de 1990. Algunos de nosotros hecho neural net-sistemas basados en cosas prácticas como detección de fraudes de tarjetas de crédito. He trabajado en un sistema automatizado de lectura de cheques con reconocimiento de caracteres.

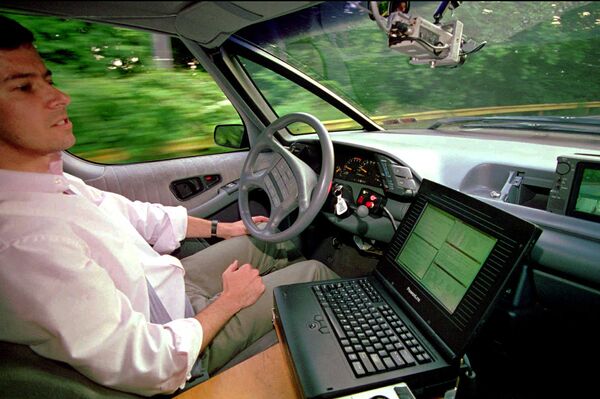

METZ: En Carnegie Mellon, un chico llamado Dean Pomerleau construyó un coche uno mismo-conducción en la década de 1980 utilizando una red neuronal. Condujo en la vía pública. LeCun utiliza la tecnología en la década de 1990 para construir un sistema que podría reconocer dígitos escritos a mano, que terminó siendo utilizado comercialmente por los bancos.

Así que a través de los años 80 y en los años 90, se produjo este resurgimiento en redes neuronales y sus aplicaciones prácticas, LeCun trabajan siendo el mejor ejemplo. Pero otra vez habían alcanzado un techo, principalmente debido a la falta de la informática potencia y datos disponibles. Entramos en otro invierno del AI.

Jürgen SCHMIDHUBER: Con los chicos canadienses, está claro que no estamos utilizando los algoritmos; están usando nuestros algoritmos. LeCun es realmente un chico francés originalmente, y estamos utilizando su algoritmo. Así que eso es bueno. Y tenía un montón de contribuciones, que fueron realmente importantes y útiles.

He conocido a estos otros chicos durante mucho tiempo. Mi primer encuentro con Yoshua fue cuando publicó lo mismo, o más o menos lo mismo, cuatro años después de que uno de mis estudiantes lo publicaron. Y luego un par de años más tarde hubo un enfrentamiento en una conferencia donde todo esto salió. Hubo un debate público en el taller, y allí estaba claro quién lo hizo primero. No era desagradable. Sólo fue aclarando las cosas. Qué ciencia es que clarificar las cosas. (Bengio ha negado los reclamos de Schmidhuber).

LECUN: El problema detrás entonces era que los métodos requieren software complicado, un montón de datos y ordenadores potentes. No muchas personas tenían acceso a esas cosas o estaban dispuestas a invertir el tiempo. Entre mediados del decenio de 1990 y mediados de la década de 2000, la gente ha optado por métodos más simples — nadie estaba realmente interesado en redes de los nervios. Era clase de un período oscuro para Geoff, Yoshua y yo. No eran amargas, pero tal vez un poco triste que la gente no quiere ver lo que todos pensamos era una ventaja evidente.

HINTON: Por supuesto, hemos mantenido creyendo en él y siguió trabajando en él, pero ingenieros descubrieron que otros métodos de trabajaban igual o mejor en pequeños conjuntos de datos, así que persiguieron esas avenidas y decidieron neurales redes eran ilusiones. El número de personas que las redes neuronales para trabajar mejor era bastante pequeño.

El Instituto canadiense de investigación avanzada tiene gente como nosotros de todo el mundo a hablar mucho más. Nos dio algo de una masa crítica.

LECUN: Hubo esta muy pequeña comunidad de personas que tenían esto en la parte posterior de su mente, que eventualmente redes de los nervios se vuelven a la palestra. En 2003, Geoff estaba en Toronto y fue abordado por Cifar para iniciar un programa de cómputos neuronales. Se reunieron y decidieron que debemos esforzarnos por reavivar el interés en nuestro trabajo.

Pero necesitábamos un espacio seguro para pequeños talleres y reuniones para realmente desarrollar nuestras ideas antes de publicarlas. El programa comenzó oficialmente en 2004 y en 2006 había papeles que fueron realmente interesantes. Geoff publicó uno en ciencia.

TRUDEAU: Aprendizaje que Canadá silenciosamente había construido las bases de la moderna AI durante este invierno más reciente, cuando la gente había dado para arriba y se movió, es especie de una validación para mí algo Canadá siempre ha hecho bien, que es ciencia pura ayuda. Le damos a gente muy inteligente la capacidad inteligente de las cosas que pueden o no pueden terminar en algún lugar concreto o comerciales.

HINTON: En 2006 en Toronto, se desarrolló este método de

formación de redes con un montón de capas, que era más eficiente. Tuvimos un papel ese mismo año en ciencia que fue muy influyente y ayudó a copia de seguridad de nuestras afirmaciones, que se interesó mucha gente otra vez. En 2009 dos de los estudiantes en mi laboratorio desarrollaron una manera de hacer reconocimiento de voz utilizando estas redes profundas, y que funcionaba mejor de lo que ya estaba hacia fuera allí.

Sólo fue un poco mejor, pero la tecnología existente ya llevaba alrededor de 30 años sin avances. El hecho de que estas redes profundas podrían hacer incluso un poco mejor durante algunos meses significó que era evidente que dentro de unos años van a progresar aún más.

METZ: En 2009, hubo este encuentro aleatorio entre Hinton y un investigador de reconocimiento de voz de Microsoft llamado Li Deng. Como casi todo el mundo, Li Deng cree en una forma diferente de IA conocida como AI simbólico. En este enfoque, básicamente había que construir el reconocimiento de voz sistemas de una línea a la vez, codificación de comportamiento específico y esto era realmente lento que va.

Hinton se menciona que su enfoque de la red neuronal para reconocimiento de voz mostraba un progreso real. Puede aprender a reconocer las palabras mediante el análisis de los patrones en bases de datos de palabras habladas, y estaba actuando más rápido que el trabajo simbólico, línea por línea. Deng no creía necesariamente Hinton, pero invitó a él y eventualmente dos de sus colaboradores a Microsoft para trabajar en la tecnología. Reconocimiento de voz tuvo un gran salto hacia adelante en Microsoft y, a continuación, Google también en 2010.

Luego, a finales de 2012, Hinton y dos de sus estudiantes tienen un avance del reconocimiento de imagen enorme donde se soplaba las técnicas anteriores. Que es cuando no sólo Microsoft y Google, pero el resto de la industria despertó a estas ideas.

La cosa para recordar es, estas son ideas muy antiguas. Lo que cambia es la cantidad de computación alimentación y datos detrás de las redes neuronales. Para ejecutar un Microsoft o Google, que necesita miles de máquinas funcionando en concierto, procesar todo, desde texto a vídeos. Esto permitió en última instancia, las redes neuronales para tener éxito. Necesita los datos para entrenarse, y necesita la potencia de cálculo para ejecutar ese entrenamiento.

LECUN: ¿Por qué tardó tanto tiempo? Que es sólo la ciencia de la manera trabaja. Su psicología. Antes de que se adopte un conjunto de técnicas, personas tienen que estar convencidos de que pueden trabajar. Estos métodos tenían una mala reputación de ser exigentes y que requieren algo de magia negra.

RICHARD SUTTON: Es profunda para ver tales incrementos constantes en la potencia de los ordenadores. Ahora estamos en un poco de una raza entre las personas tratando de desarrollar los algoritmos y la gente tratando de desarrollar equipos más rápidos y más rápidos. Tienes que tipo de plan para sus algoritmos de AI trabajar con los equipos que estarán disponibles en tiempo de 5 años y 10 años.

El equipo tiene que tener un sentido de lo que es bueno y lo que es malo, y por lo que dar una señal especial llamada una recompensa. Si la recompensa es alta, significa que es bueno. Si la recompensa es baja, significa que es malo. Es de donde viene un propósito.

Una red neural es donde almacenas el aprendizaje y refuerzo es cómo decidir qué cambios te gustaría hacer.

BENGIO: Somos todavía un largo camino desde el tipo de aprendizaje no supervisado que Geoff, Yann y soñar. Prácticamente cada producto industrial basado en aprendizaje profundo se basa principalmente en aprendizaje supervisado, donde tienen computadoras que se les diga qué hacer en millones de casos. Y por supuesto, los seres humanos no aprenden de esa manera; aprender autónomamente. Descubrimos el mundo alrededor de nosotros por nosotros mismos. 2 años de edad tiene nociones intuitivas de la física, gravedad, presión y así sucesivamente, y sus padres nunca la necesidad de decirle sobre las ecuaciones de Isaac Newton para la fuerza y gravedad. Interactuar con el mundo, observar y de alguna manera construir un modelo mental de cómo las cosas se desarrollan en el futuro, si hacemos esto o aquello.

Estamos entrando en una nueva fase de la investigación en aprendizaje no supervisado, que conecta con el trabajo de refuerzo. No sólo estamos observando el mundo, pero estamos actuando en el mundo y luego usar el efecto de esas acciones para averiguar cómo funciona.

LECUN: Estoy interesado en conseguir máquinas para aprender tan eficientemente como animales y seres humanos. Cuando aprendes a conducir, usted sabe que si se baja el camino, le suceden cosas malas. Podemos predecir las consecuencias de nuestras acciones, que significa que no tenemos que hacer algo malo para darse cuenta de que es malo.

Por lo tanto, lo que busco es encontrar maneras de máquinas de tren por lo que pueden aprender por observación, por lo que pueden construir los modelos de predicción del mundo. Cada animal vivo tiene un modelo predictivo de su entorno. Más inteligentes que son, el mejor en hacerlo. Se podría decir que la capacidad de predecir es realmente la esencia de la inteligencia, combinada con la capacidad para actuar en tus predicciones.

LECUN: Es muy posible que vamos a hacer algunos progresos durante los próximos 3 años, 5 años, 10 años o 15 años, algo bastante cercano. Va a tomar mucho tiempo después de en realidad construir sistemas alrededor de esto en algún lugar cerca de la inteligencia humana. Tomará décadas.

BENGIO: No creo que los seres humanos será necesariamente fuera de puestos de trabajo, incluso si las máquinas se convierten en muy inteligentes y tal vez incluso más inteligente que nosotros. Te queremos siempre personas para puestos de trabajo que realmente acerca de las interacciones humanas. No quiero un robot cuidando de mis bebes, o abuelos o a mí cuando estoy enfermo en el hospital. No me preocupa la situación de Terminator. Creo que si somos capaces de construir máquinas que son tan inteligentes como nosotros, también será lo suficientemente inteligentes como para entender nuestros valores y nuestro sistema moral y para actuar de una manera que es buena para nosotros.

Mi preocupación real es por el posible mal uso de la IA, por ejemplo como armas aplicados militares. Ya se está utilizando para influir en la gente, como se puede ver en la publicidad. En lugares donde la implementación de la AI es moralmente o éticamente incorrecto, creo que sólo debemos hacer ilegal. Tenemos que ser colectivamente más sabio.

SUTTON: Creo que es un gran error que hemos llamado la “artificial intelligence” del campo. La hace parecer como que es muy diferente de la gente y como no es verdadera inteligencia. Hace que la gente piense en ello como más extranjero de lo que debería ser, pero es algo muy humano que estamos tratando de hacer: volver a crear la inteligencia humana.

La ciencia siempre ha revelado verdades que no todas las personas, se obtiene t

verdad pero no siempre el que quería. Tal vez por esta razón la religión ha sido históricamente reñidas con la ciencia. Creo que el mismo será medida que aprendemos más acerca de la mente. Tal vez no será una explicación de la conciencia. Algunas personas les gusta y algunas personas no les gusta eso. La ciencia no puede cambiar lo que es cierto.

Siempre habrá ganadores y perdedores cuando hay cambio y hay gran cambian que viene. Creo que seremos las máquinas inteligentes. Debemos pensar en el AIs como nosotros mismos o nuestros hijos. Podemos crear para ser como mejor nos parezca.

¿Qué es la humanidad? Es un esfuerzo ser mejor. No queremos congelar como somos ahora y decir que es lo que siempre debe ser.

Contact Information:

Ashlee Vance

Tags:

, Wire, Artificial Intelligence Newswire, United States, Spanish

Keywords: afds, afdsafds